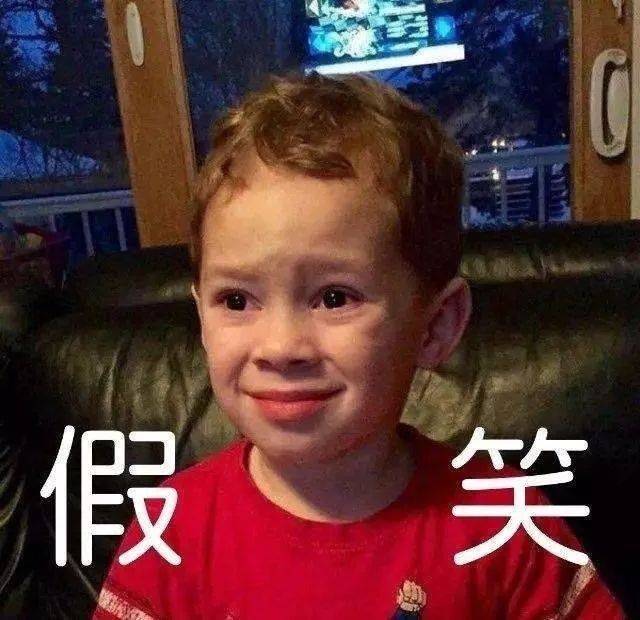

图片来源:视觉中国 据最新的一项调查,世界人民三观并不一定相同,但在识别“假笑”这件事儿上却基本上都能做

图片来源:视觉中国

据最新的一项调查,世界人民三观并不一定相同,但在识别“假笑”这件事儿上却基本上都能做到。不管身处哪个国家,人们基本上都能更好地分辨出笑声到底是真的还是假的。

这是因为自然笑容的肌肉、声音和硬挤出来的笑容肌肉、声音是截然不同的,比如紧绷度和流畅度。打个比方,你很容易看出来“假笑男孩”是在“假笑”。

那么,既然人能识别“假笑”,那机器能不能做到?或者说,以目前的技术发展水平来说,人工智能是否可以通过识别技术来对人进行情绪识别进而做出相应的反应呢?

我们知道,目前人工智能最成熟的应用之一就是图像和语音识别,其已经广泛应用到拍照识物、画面增强、人机交互等各种领域。但显而易见的是,目前其很大程度上还是处于识别和归类的层面,想要透过表层的识别去进行深层的情绪认识和理解,进而优化人机交互的体验,尚需时日。

但这并不代表人们对人工智情绪识别的望尘莫及。作为对人的表层识别的深层次延伸,情绪识别带来的变化将是非常积极的。那么,如今的人工智能情绪识别到底发展怎样?它离进入我们的现实生活,到底还有多远?

情绪大都一样,手法各有不同

我们知道,人的情绪体现是多方面的。表情、语言、动作等,都可以作为人类表达情绪的载体。不同的情绪会以不同的形式体现出来,比如一个人开心的话就会笑,嘴巴两边向上翘起,眼角也会微翘;如果特别开心的话,会“哈哈”大笑。那么,很多研究者就抓住各种情绪对应的表情或动作,来对机器进行训练和学习。

可以说,凡是能反映情绪的地方,都已经被研究者们翻遍了。

眼球转动分析个性。民科对眼球转动体现人的心理活动早就有过一些总结,比如兴奋的时候两眼放光,沮丧的时候两眼无光,悲伤的时候瞳孔无神,愤怒的时候怒目圆睁等等。还有人认为眼球向左上方看是说谎,右上方看则是思考。无论科学与否,其总归是证明眼球对判断人的性格、情绪是由一定的作用的。

比如最近由德国斯图加特大学、澳大利亚弗林德斯大学和南澳大利亚大学的研究人员组成的团队就开发出了一种机器学习算法,其通过对系统进行大量的训练,调查了42位受试者日常生活中的眼球转动情况,然后去评估性格特征。比如该算法可以显示关于个人的交际能力、好奇心等,并且能与识别出大五人格中的四种。那么,能从总体上来判断一个人的性格,某种程度上就缩小了需要识别的情绪的范围。

微表情分析。很多情况下,人的情绪并不是大起大落的,所以情绪更多的是从微表情上体现出来,比如动动嘴角、眨眨眼睛。比如翻眼珠的动作可能会表示不屑一顾。因此,作为与情绪直接相关的一部分,关于微表情的研究成为众多公司竞相上马的项目。

最近麻省理工就通过机器学习来捕捉面部表情的细微变化,从而衡量一个人的心理感受。通过把18段视频分解为一帧一帧的图片,模型可以通过学习来获得相应表情背后的情绪。最主要的是,它有别于传统表情识别的一刀切,可以根据需要进行重新训练,具有高度的个体适用性。

语言表现分析。除了观色之外,判断人的情绪的另一个直观方法就是“察言”。比如说话声音的高低、打字速度的快慢等等。

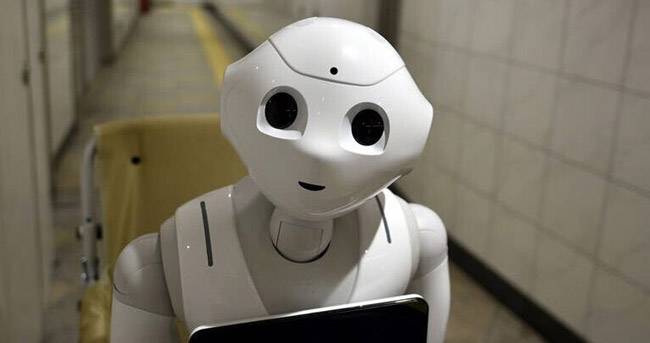

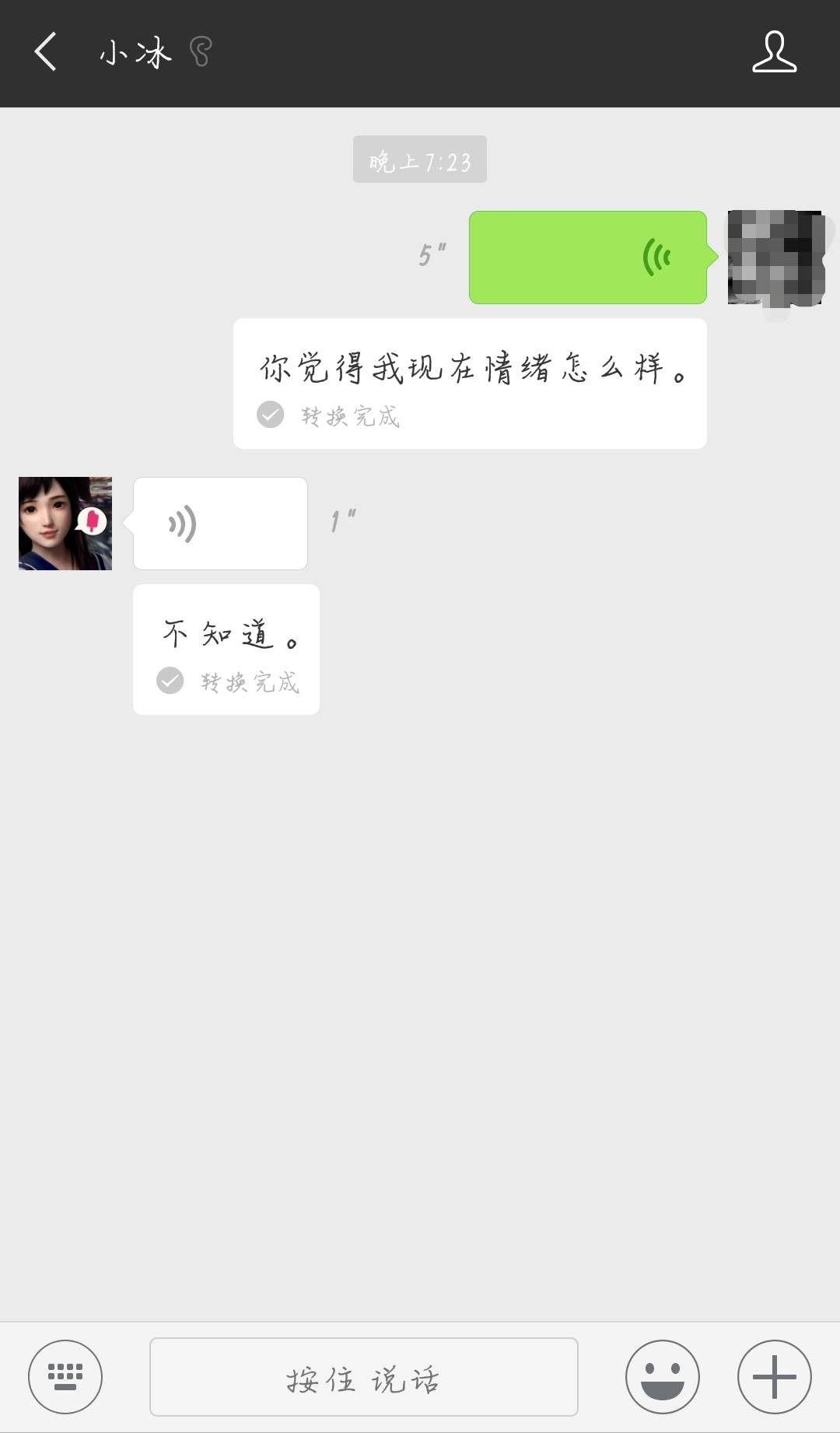

日本软银公司的情感机器人pepper,其搭载的摄像头让其具备表情识别的功能,同时又可以基于云端的语音识别来实现对人说话的语调识别,从而获取人的说话情绪,来实现其所标榜的“情感机器人”的功能。同时,IBM开发的能感知情感的在线客服系统,也可以通过学习识别藏在语法、打字速度中的人的情绪,类似的对话式情感识别人工智能还有微软的小冰等。

除此之外,结合可穿戴设备来获取人的脉搏频率等体征也将有助于情感的获得。总之,在人脸识别、语音识别、传感器和各种数据算法的加持下,人工智能识别情绪看起来呈现出欣欣向荣的态势。

研究者的“小山头”,或是情绪识别“笨笨的”之因

然而,我们从以上的研究现状当中可以看到比较明显的研究特点。

第一,技术研究呈现“小山头”。即很多研究者都在试图通过自己所擅长的技术领域去进行解释和实验,比如有的擅长图像识别,有的擅长语音识别,有的则擅长传感器数据分析等。这些研究者或研究团队往往拥有自己的技术优势,但也存在一定的短板。

第二,技术研究的实验室限制。虽然三岁小孩儿都会“看人脸色”,但这对机器来说已经殊为不易。因此,目前的情绪识别仍然处于起步阶段,很多技术还存在于实验室或论文当中。而这离走进现实,至少要三五个年头。

即便是一些公司研发出成品应用,其也一直饱受诟病,显得笨笨的。比如pepper常被吐槽总是听不清人说的话,小冰受到的吐槽更是一言难尽。技术尚未成熟就推出产品,其用户粘性自然不值一提。

那么,为什么情绪识别对pepper、小冰们来说这么难呢?

正常来说,利用机器识别人的表情从而进行情绪判断是非常有想象力的,而且远景诱人。因为即便是人,有时候也很难察觉一些一闪而过的表情,导致无法判断对方此时的心理情绪。但是拥有了成熟图像识别和声音捕捉能力的人工智能,处理这些事情看来应该是如砍瓜切菜。

那么,导致人工智能“笨笨的”的现状,也算是事出有因了。

比如我们上文分析过的一个原因。各研究团队或公司往往是利用一种或两种识别技术进行情绪判断,或抓住某个微表情、某一个声音,这显然是不完善的、片面的。比如“愤怒”和“激励”两种情绪,疯狂的激励往往表现为离奇的愤怒,同样都是怒目圆睁、吼声震天,人工智能该如何把这两种情绪识别开?

这时候,单纯的表情识别和声音识别就体现出局限性了,其还有必要加入动作识别。比如手是握紧拳头的加油状,还是食指指向对方的挑衅状。如果再加上语言内容识别等其他因素,形成一个综合性因素的判断,将更有利于情绪的精准识别。

也就是说,情绪识别也就不仅仅是“察言观色”的事儿,还必须要“观其行”,对人进行全方位、立体式分析。

此外,情绪识别还有可能因为虚假的表象而增加难度。比如文章开头提到的假笑。单单是识别人们的最直观情绪就已经困难重重,如何去破解隐藏在伪装背后的情绪就显得更为棘手。

(非常低落而缓慢地跟小冰说话得到无情回答)

但情绪识别的难度显然并非仅仅是我们以上分析的几点。原因在于,情绪是一种心理行为,其也会由于个体的不同而展现出不同的表现形式,比如不同的文化当中同一手势就代表不同的意思,就像贴面在有的国家是礼节行为,在有的国家就是流氓行径。

因此,情绪与心理相关的复杂性导致其与人的动作、表情并不一定呈必然相关性。但这并不意味着就没有研究它的意义,反而让我们能够明确:研究情绪识别并不是一定要令每种情绪都有对应的外在表现,而是能够最大程度地利用人工智能帮助我们理解情绪,从而挖掘更多的可能。

不仅能聊天,还能破个案?

那么,人工智能情绪识别能力的提升,究竟可以给我们提供哪些方面的便利之处?

首先,人机交互的体现更加自然顺畅,也将直接扭转人们日常对“人工智能”的“人工智障”评价。这对于空巢老人、儿童的陪护将起到积极的作用。通过对人的情绪捕捉,它可以为老人儿童提供心理安慰。而在这个基础上,利用人工智能进行情绪识别也能更好地帮助解决心理疾病问题,分担心理医生的精力。尤其是在对话这块儿,成熟的人工智能会在对话的过程中照顾到患者的情绪,从而慢慢地缓解病情。

并且,在对老人的看护之中,其还可以根据微表情的识别来判断老人是否有老年痴呆的情况,从而能够及时作出提醒。比如上文提到的麻省理工开发的情绪识别算法,既识别了情绪,必然对微表情能够进行熟练而准确的分析。

其次,情绪识别能够帮助提高犯罪审讯的效率。影视剧中经常出现的一幕是,嫌犯坐在审讯室若无其事,任凭警察如何审讯,其始终一言不发。而我们知道,警方在利用掌握的已知证据“诈”嫌犯的时候,也是非常想知道嫌犯的心理底线到底还有多远。

那么,在审讯室装个摄像头、传感器,另一边的技术室实时进行对嫌犯的脉搏、体温、表情、喉结蠕动等各个细节的分析检测,更有助于掌握嫌犯的心理变化情况,从而对审讯进程了如指掌。比如宜兴市检察院就和中国政法大学联合建立了微反应实验室,并且通过对犯罪嫌疑人转瞬即逝的表情的成功捕捉,调整了审讯的方向,成功引导嫌犯交代事实。

可以预见的是,随着情绪识别的成熟,这项技术将很快会部署到警务系统当中。

最后,微表情将对涉及安全作业的情况对人进行实时提醒。现代社会工作呈现出高强度的态势,人们为了生存几乎都在疲于奔命,比如司机。

疲劳驾驶是造成车祸的主要原因之一,尤其在高速上。往往是一秒钟的打盹,造成了一辈子的悲剧。如果车辆在出厂的时候就配置了以情绪识别为主要构成的疲劳驾驶提醒系统,在司机打哈欠、眯缝眼、乃至“磕头”的时候不断进行警报提醒,并提出休息建议,将可以在一定程度上降低车祸发生概率。

此外,利用情绪识别来管理和控制情绪也可能会成为一些情绪易失控者的福音。

总之,尽管情绪识别目前还很单薄,不足以令其成为粘度很高的日常产品。但可以肯定的是,一旦技术成熟,其带来的益处将不仅仅是工业级的,更是贴近最广大的消费者。当情绪可以被当作读懂自己的镜子,人们也就可以获得更多来自他“人”的理解,从而解决更多实际生活中的难题。

可是,你有没有想过可能由此而来的另外一个难题:鉴于深度学习的黑箱问题尚未解决,万一人工智能具备了自主的人类情感怎么办?

那还能怎么办?准备拿起武器战斗吧……

-

电动车充电慢?北汽新能 电动车即将没电?开到换电站,全程扫描...

-

iPhone 8要出新皮肤?传苹果 美国运营商Virgin Mobile发给员工的一份内部...

-

Oculus视频负责人:VR将为电 你喜欢在看电影时吃爆米花吗?如果是的...

-

打破理所当然,OPPO Find 6 月 12 日,OPPO 官方微博发布最新产品猜...

-

不只是表,更是生活 Pac 说起智能穿戴产品大家第一个想到的肯定...

手机版

手机版 网站地图

网站地图